Müssen Algorithmen sterben, damit wir leben können?

Überlegungen zu Tod und Technik mit einem (ernsten) Augenzwinkern

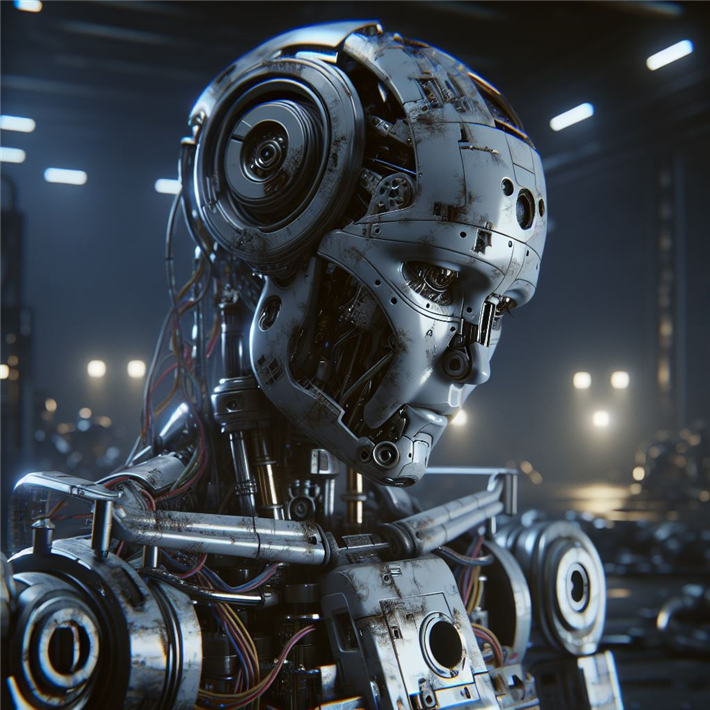

Als Sam Altman, der CEO von OpenAI, mit ChatGPT die erste leistungsfähige generative KI (Künstliche Intelligenz) vorstellte, die die Welt wie keine andere Software zuvor in atemberaubendem Tempo erobern und umgestalten sollte, zog er den Vergleich zur Erfindung der Atombombe. KI hätte angesichts weiterer bevorstehender Durchbrücke das Potential, die Menschheit auszulöschen und müsse daher, wie die Atomwaffe, streng reguliert werden…

© Microsoft Copilot

© Microsoft CopilotKI, Kreativität und Krieg

Dass von KI konkrete Gefahren für Freiheit und Demokratie ausgehen, lässt sich tagtäglich an den Falschinformationen und Manipulationen in den sozialen Medien sehen. Man sieht es auch in der Konkurrenz von immer besser werdenden Algorithmen für Schriftsteller, Drehbuchautoren, Fotografen, Komponisten, Grafiker und viele weitere kreative Menschen. Immer mehr dringen algorithmischen Automated Decicion Makers, die Entscheidungen treffen, die traditionell von Menschen getroffen wurden, in immer mehr Bereiche unseres Lebens ein. Und ja, es wird auch an KI-gesteuerten autonomen Waffen geforscht.

Könnte es da helfen, dass Algorithmen „sterben" müssen? Können wir unser Überleben sichern, indem wir der Technik den Tod beibringen? Die Frage klingt nach Maschinenstürmerei gegen KI. Doch ebenso wenig wie der Kampf der Luddisten in der englischen Textilindustrie im 19. Jahrhundert kann ein Sturm auf die Digitalindustrie heute auch nur einen Funken Erfolgsversprechen in sich tragen. Wie sich von den Protesten der Arbeiter gegen die automatischen Webstühle der Gang des technischen Fortschritts nicht stoppen ließ, so erscheinen auch heute die Proteste etwa von Drehbuchautoren oder Werbetexter*innen in USA und deren pauschale Bekämpfung der automatischen Textmaschinen nicht aussichtsreich.

Vom Nachteil, unsterblich zu sein

Die Frage nach der Sterblichkeit zielt auf etwas anderes: Darauf, den schier unbegrenzten Tätigkeiten der KI eine Endlichkeit einzuprogrammieren, ihr ein Stoppschild aufzustellen: Rechne bis hierhin und nicht weiter. KI hat nämlich bis heute ein Problem: Sie kann nicht entscheiden, wann sie mit den Berechnungen aufhören soll. KI-Pionier Allen Turing nannte es das Halteproblem. Es besagt, dass es aus mathematisch-logischen Gründen unmöglich ist, dass ein Algorithmus für jeden denkbaren Algorithmus festlegt, wann dieser in seinen Berechnungen an ein Ende kommt. Das bedeutet, dass es KI nicht möglich ist, über die eigenen Operationen zu reflektieren. Sie kann daher auch nicht eingesetzt werden, andere KI-Systeme zu überwachen, um sie im Fall von Gefahren einzudämmen.

Das Kontroll- und Eindämmungsproblem, das auch darin besteht, dass sich intelligente Systeme ab einer bestimmten Entwicklungsstufe nicht mehr abschalten lassen, beschäftigt die Forscher weltweit und ist mit ein Grund, warum sie in immer neuen Erklärungen vor den Gefahren ungebremster KI-Entwicklung warnen und die Politik zum Handeln auffordern.

Geplante KI- Obsoleszenz als Ausweg

Wäre es ein Ausweg, Algorithmen sterblich zu machen? Das könnte etwa durch geplante Obsoleszenz für KI-Systeme erfolgen. Ihnen würde ein Todeszeitpunkt einprogrammiert, der festlegt, dass sie an einem festgelegten Datum ihren Betrieb einstellen. Heute werden Algorithmen eingesetzt, um Produkte schneller unbrauchbar zu machen als erforderlich. Könnten nicht auch Algorithmen diesem geplanten Verfall ausgesetzt werden? Würden sie dann weniger Gefahren bergen, würden sie dann vielleicht sogar menschlicher werden?

Zurzeit stehen KI-Programme eher im Dienst der Unsterblichkeit: Zu den skurrilsten und beängstigendsten Marotten des Silicon Valley zählen die zahlreichen ernstgemeinten Versuche, mithilfe von KI und Biotechnologie den Tod zu besiegen. Milliarden fließen in Unternehmen von Googles Caligo oder das vor Jeff Bezos finanzierte Altos Labs, das allein 2022 drei Milliarden Dollar einsammelte, um Nobelpreisträger und führende Forschende verpflichten zu können. Ihr alleiniges Ziel: dem Tod durch Technologie ein Schnäppchen zu schlagen. Bei diesen Technologieunternehmen, die sich dem Kampf gegen den Tod verschrieben haben, ruhen die Hoffnungen in erster Linie auf dem schnellen Fortschritt bei KI. Sie soll die wissenschaftlichen Durchbrüche herbeiführen, die den Silicon Valley Milliardären unendliches Leben beschert. Der Wunsch ist verständlich, ist er doch sehr menschlich. Außerdem: Wie außer in einem unendlichen Leben kann Jeff Bezos die 214,28 Milliarden Dollar, die er besitzt, selbst ausgeben?

Todesalgorithmen statt menschlicher Verantwortung

Unsterblichkeit für Milliardäre - für die weiterhin Normalsterblichen hingegen berechnen Algorithmen dem nahezu exakten Todeszeitpunt: Forscher enthüllten kürzlich einen verstörenden KI-Algorithmus namens "life2vec", der anhand der Lebensgeschichte eines Menschen mit beängstigenden 78 % Genauigkeit vorhersagen kann, wann er stirbt. Für den Algorithmus wurden Daten von über sechs Millionen Menschen mit Faktoren wie Einkommen, Beruf und Wohnort analysiert, um ein Chatbot-Modell zu entwickeln. Die in Nature Computational Science veröffentlichte Studie zeigte, dass der Bot in über 75 % der Fälle korrekt vorhersagte, wer im Folgejahr starb.

Auch in der Palliativmedizin werden längst Algorithmen eingesetzt: Das von Google mitfinanzierte Unternehmen Aspire Health wertet mit ihrer Hilfe ärztliche Diagnosen von Patienten aus - und gleicht das Krankheitsbild mit Mustern häufiger Therapien ab. So soll verhindert werden, dass Schwerkranke unnötige Behandlungen bekommen, die außerdem noch viel Geld kosten. Es spart teure Untersuchungen, wenn man zu wissen glaubt, dass es um den Patienten ohnehin bald geschehen ist. Aspire Health, das sein Geld mit Palliativpflege verdient, erwartet, dass sich so 40 Prozent der Behandlungskosten einsparen lassen. Todesalgorithmen, die Entscheidungen über Leben und Tod nach Kostengesichtspunkten vorbereiten oder gleich ganz treffen, sind also schon Alltag. Und das tun sie ausschließlich auf der Basis statistischer Berechnungen. Andere Faktoren bleiben bei ihren Prognosen außen vor, zum Beispiel der individuelle Überlebenswille.

Dieser muss allerdings gegen den Vormarsch algorithmischer Entscheidungssysteme in immer mehr Lebensbereichen in Stellung gebracht werden, wenn das Menschliche nicht verloren gehen soll. Und zum Menschlichen gehört auch die Sterblichkeit.

Ewiges Leben und die Konsequenzen unseres Handelns

Wer ewig lebt, kann das Leben nicht wertschätzen, kann das Geheimnis der Lebendigkeit nicht erfahren. Algorithmen können das nicht. Und Milliardäre, die davon träumen, mithilfe von KI Unsterblichkeit zu erlangen, anscheinend auch nicht. Womöglich kann an einer guten Zukunft nur arbeiten, wer um die eigene Endlichkeit weiß. Sollte also KI sterblich gemacht werden, um ihre Gefahren einzudämmen und sie „menschlicher" zu machen? Oder würde eine KI, die „weiß", dass sie abgeschaltet wird, erst recht angespornt werden, sich dem zu entziehen. Eine KI, die die Fähigkeit hätte, über ihr Ende und damit über ihr eigenes Dasein nachzudenken, können wir uns nicht wünschen. Bei ihrem Versuch die Probleme der Welt möglichst effizient zu lösen, würde eine wirklich „intelligente" Künstliche Intelligenz nämlich das derzeit größte Problem des Planeten entdecken und eliminieren: den Menschen, der Raubbau an der Natur betreibt und dabei ist, seine eigenen Lebensgrundlagen zu zerstören.

Bleiben wir also lieber bei unserer Sterblichkeit und machen wir uns daran, mit unserer menschlichen Intelligenz und unserem Überlebenswillen die Grundlagen des eigenen Lebens und Überlebens zu sichern. Dazu zählt, Verantwortung für das eigene Handeln zu übernehmen, auch über die eigene Lebensspanne hinaus. Damit allein können wir uns unsterblich machen. Und dazu gehört auch, die Macht übermenschlicher Maschinen einzudämmen und zu kontrollieren. Aber Sie auch gleichzeitig in den Dienst einer erstrebenswerten Zukunft zu stellen.

Matthias Pfeffer ist Philosoph, TV-Journalist, Buchautor, Produzent und Gründungsdirektor des Council for European Public Space. Er war lange Kriegs- und Krisenreporter, danach Geschäftsführer und Chefredakteur von FOCUS TV. Er ist Co-Autor des Buches „Prinzip Mensch: Macht, Freiheit und Demokratie im Zeitalter der Künstlichen Intelligenz", 2021 folgte: „Menschliches Denken und Künstliche Intelligenz: Eine Aufforderung".

Technik | Digitalisierung, 01.01.2025

Save the Ocean

forum 02/2025 ist erschienen

- Regenerativ

- Coworkation

- Klimadiesel

- Kreislaufwirtschaft

Kaufen...

Abonnieren...

30

APR

2025

APR

2025

Franz Alt: Die Solare Weltrevolution - Aufbruch in eine neue Menschheitsepoche

In der Reihe "Mein Klima… in München"

80331 München und online

In der Reihe "Mein Klima… in München"

80331 München und online

07

MAI

2025

MAI

2025

MakerCamp Genossenschaften 2025

Genossenschaftliche Lösungen in Wirtschaft, Kommunen und Gesellschaft

65189 Wiesbaden

Genossenschaftliche Lösungen in Wirtschaft, Kommunen und Gesellschaft

65189 Wiesbaden

21

MAI

2025

MAI

2025

LVR-Kulturkonferenz 2025: Kultur. Nachhaltig. Wirtschaften.

Welchen Beitrag leistet Kultur zum wirtschaftlichen Wachstum?

47805 Krefeld

Welchen Beitrag leistet Kultur zum wirtschaftlichen Wachstum?

47805 Krefeld

Professionelle Klimabilanz, einfach selbst gemacht

Einfache Klimabilanzierung und glaubhafte Nachhaltigkeitskommunikation gemäß GHG-Protocol

Politik

Sind wir alle viel zu geldfixiert geworden?

Sind wir alle viel zu geldfixiert geworden?Mit Blick auf auf das Börsenchaos überlegt Christoph Quarch, was ein gutes Leben ausmacht